Von Klaus Abstein am 16.12.2021 (Lesezeit: ~11 min.)

Isaac Asimovs Foundation-Trilogie - die zuvor als einzelne Novellen in Groschenheften (sog. Pulp-Fiction) erschien und erst später zu Büchern gebündelt wurde - gilt als die beste Science-Fiction Erzählung aller Zeiten und begründete ein ganzes Genre an Zukunftserzählungen. Auch George Lucas bediente sich für Star Wars vieler Element aus Asimovs Werken, wie hier im Artikelbild, das den Herrschaftsplaneten Coruscant aus Star Wars zeigt und an den Planeten Trantor des galaktischen Imperiums Asimovs angelehnt ist.

Isaac Asimov: Foundation-Triologie

Für alle, die dieses Meisterwerk nicht gelesen haben, hier eine kleine Zusammenfassung des Werks:

Im Jahr 12.068 steht das galaktische Imperium auf der Höhe seiner Macht. Doch Hari Seldon, der Begründer der Psychohistorik - einer Wissenschaft, die sich mit der Entwicklung und Voraussage sozialer Gebilde beschäftigt - sagt den drohenden Untergang des Imperiums voraus, ebenso wie darauffolgende 30.000 Jahre der Barbarei. Er entwickelt einen komplexen Plan, um diese Zeit auf 1.000 Jahre zu verkürzen und gründet zwei Foundations an den verschiedenen Enden der Galaxie, die durch Krisen und soziale Ereignisse in den nächsten 1.000 Jahren auf einem vorbestimmten Pfad gehalten werden sollen.

Wenn man das Buch zum ersten Mal liest, ist man von dem Seldon-Plan erstmal ein wenig überwältigt, da man sich einen Plan mit solcher Präzision über solch einen langen Zeitraum kaum vorstellen kann. Wenn man dann weiterliest und die erste Foundation an den Rand des Universums nach Terminus verlagert wird, um eine Enzyklopädie des gesamten menschlichen Wissens anzufertigen, kommt einem dies als ein vernünftiger Plan vor. Jedoch wird man im nächsten Kapitel eines Besseren belehrt, da nach 50 Jahren Foundation herauskommt, dass das Anfertigen der Enzyklopädie lediglich eine Beschäftigungsmaßnahme war, um die Foundation in eine Lage zu bringen, in der sie die umliegenden Gebiete technologisch-religiös unterwerfen muss, um nicht unterzugehen.

Unabhängig von dieser dramaturgischen Wendung, erscheint es aber sinnvoll, sich näher mit den Enzyklopädisten und deren Vorhaben zu beschäftigen, denn tatsächlich ist der Fortschritt von Zivilisationen eng mit dem vorhandenen Wissensschatz verknüpft.

So ist es nicht verwunderlich, dass die Sumerer als erste Hochkultur auch das erste Schriftsystem entwickelten, was bewirkte, dass Wissen nicht mehr nur mündlich überliefert wurde, sondern auch langfristig festgehalten werden konnte.[1] Mit dem Anstieg von Wissen nahm auch der Fortschritt der Zivilisation zu und mächtige Hochkulturen besaßen daher auch einen großen Wissensschatz in Schriftform. Das prominenteste Beispiel ist hier die Bibliothek von Alexandria, die heutigen Erkenntnissen nach bis zu 500.000 Schriftrollen beherbergt haben soll.

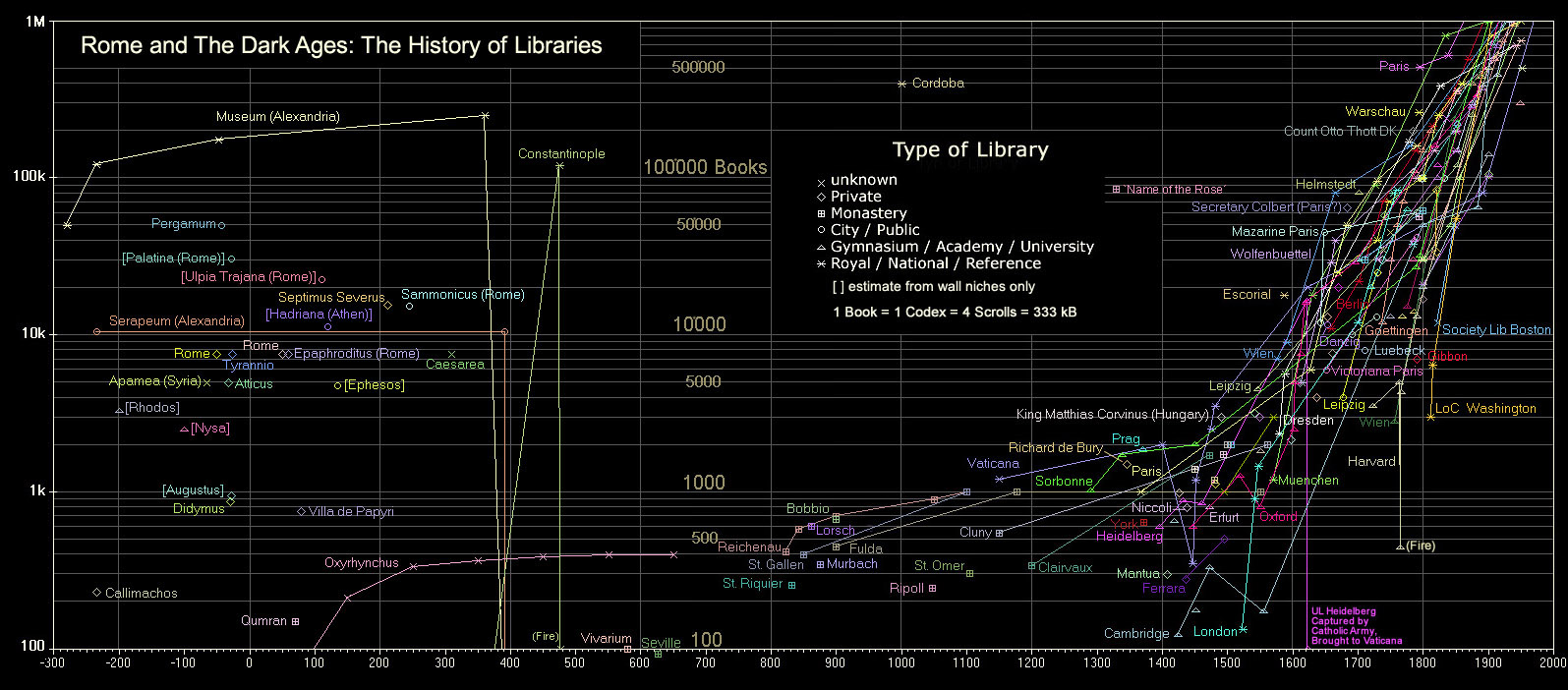

Wenn man sich als historisches Beispiel den Übergang der Antike zum Mittelalter nimmt, sieht man, dass während des Untergangs des römischen Reichs in der Spätantike und der Völkerwanderung massiv Wissen verloren ging. Ein Großteil der Werke der gewaltigen Bibliotheken ging verloren und es dauerte bis ins 19. Jahrhundert, bis es erstmalig wieder solch gewaltige Ansammlungen an Wissen gab.[2] Dieser Verlust gepaart mit der religiösen Unterdrückung wissenschaftlicher Erkenntnisse führten zu dem, was wir heute als "finsteres Mittelalter" bezeichnen. Dieser Begriff verzerrt zwar stark, dass es auch im Mittelalter einen großen kulturellen Schub gab, gibt jedoch richtig wieder, dass Bildung und Wissen über Naturwissenschaften und Philosophie stark abnahmen.

Anzahl von frei zugänglichem Wissen in Bibliotheken. sVon Wikimedia Commons unter der CC BY-SA 3.0 Lizenz

Heute mag uns die aktuelle weltpolitische Lage gefestigter denn je erscheinen, doch viele der vor uns liegenden Herausforderungen bieten genug Potentiale, dies wieder zunichtezumachen. Zugleich erleben wir weltweit das Phänomen erstarkender national-populistischer Bewegungen, die eine immanente Gefahr für das Wissen als auch für die politische Stabilität darstellen. Unter diesen Umständen sollte sich daher mit der Frage beschäftigt werden, wie die Menschheit eine allumfassende Wissenssammlung schaffen kann, die unabhängig von Politik und Naturkatastrophen das Wissen permanent zur Verfügung stellt.

Probleme bei der Umsetzung

Rechtliche Probleme

Mit Googles Ansatz einer digitalen universellen Bibliothek wurde etwas Ähnliches bereits versucht. Dazu scannt Google in einem eigens entwickelten Verfahren riesige Bestände von Bibliotheken ein, um diese dann anschließend mittels Texterkennung digital zugänglich und durchsuchbar zu machen. Doch, obwohl das Projekt mittlerweile über 40 Millionen Bücher in mehr als 400 Sprachen gesammelt hat, ist die Sammlung noch lange nicht vollständig.[3] Das liegt vor allem an den juristischen Grundlagen für ein solches Projekt. Google musste bislang einige Rückschläge in Rechtstreits mit Autoren und Verlagen hinnehmen und kann daher lediglich rechtefreie Texte zur Verfügung stellen. Dies ist das erste Problem einer solchen allumfassenden Wissenssammlung: Die Eigentumsverhältnisse von Wissen.

Ein anderes Problem besteht darin, dass das Internet momentan ein riesiges Gebilde an Wissen und Errungenschaften der Menschheit abbildet. Es kann aber auch sehr schnell abgeschaltet oder zensiert werden, was häufig in autokratisch regierten Ländern geschieht. Aber nicht nur in China und Nordkorea wird das Internet zensiert, sondern auch an privaten Stellen. So wird Google regelmäßig vorgeworfen, mit ihrem Suchalgorithmus und dem Ranking der Themen Einfluss zu nehmen.[4] Aber auch die deutschen Internetprovider - die Teil der "Clearingstelle Urheberrecht im Internet" (CUII) sind - nehmen eine Zensur des Internets vor. Sie entscheiden aktuell, was aus urheberrechtlichen Gründen gesperrt wird und was nicht. Wo vorher Gerichte nach rechtsstaatlichen Grundsätzen entschieden, entscheiden jetzt Internetprovider und Verbände der Unterhaltungsbranche nach eigenem Ermessen.[5] Dies ist eine gewaltige Gefahr für die freie Zugänglichkeit von Wissen im Internet, wenn Staaten und ein kleiner Kreis von Unternehmen über den Zugang zu Informationen entscheiden.

Speicherprobleme

Neben rechtlichen und rechtstaatlichen Themen ist aber auch die Frage der Aufbewahrung ein (noch) elementares Problem: Denn die Daten müssen ausfallsicher, dauerhaft gespeichert werden und gegen die wahrscheinlichsten Katastrophenszenarien abgesichert sein. Dies beinhaltet neben Umweltkatastrophen globalen oder stellaren Ausmaßes auch Szenarien wie einen nuklearen Weltkrieg oder jeglicher anderer gesellschaftlicher Zerfall.

Dadurch sind aktive Datenarchivierungssystem wie In Memory Datenbanken - die ihre Daten dauerhaft im Hauptspeicher halten - schonmal ausgeschlossen, da sie ohne dauerhafte Stromzufuhr ihre Daten verlieren. Aber auch Speichermöglichkeiten, die ohne konstante Stromzufuhr auskommen, sind nicht so leicht zu realisieren. Hierbei muss nämlich auch davon ausgegangen werden, dass es keinen Verschleiß geben darf und die Aufbewahrungsmethode robust gegenüber einer jahrtausendelangen Lagerung sein muss. Die gängigsten Speichermedien wie Hard Disk Drives (HHD) - die Informationen als elektromagnetischen Wert festhalten - oder Solid State Disks (SSD) - die ihre Informationen in Transistoren als Ladung speichern- sind dadurch ausgeschlossen, da sie zu stark auf externe Einflüsse wie Erschütterungen, Elektromagnetismus oder induzierte Ladungen reagieren.

Bislang wurden daher meist Mikrofilme genutzt, wenn es darum ging, Daten langfristig zu konservieren. Diese sind - ordentlich verpackt - recht robust gegenüber Umwelteinflüssen und können ebenfalls große Datenmengen auf kleinstem Raum komprimieren.

Codierung von RNA (links) und DNA (rechts). Von Wikimedia Commons unter der CC BY-SA 3.0 Lizenz

Eine andere Methode, die ebenfalls vielversprechend klingt, aber aktuell noch nicht serientauglich ist, ist das Speichern von Daten in dem Baustein, der sämtlichen Code für Leben enthält: der DNA. Ähnlich wie bei der binären Codierung von Informationen werden hier Informationen mit den Nukleinbasen Adenin (A), Thymin (T), Guanin (G) und Cytosin (C) gespeichert und damit auf extrem kleinem Raum in einer stabilen Struktur gespeichert. Zur Haltbarmachung der DNA kann nach der Codierung Glas molekular um die Struktur herum wachsen gelassen werden.

Dadurch entsteht ein Speichermedium, das – wenn kühl und lichtgeschützt gelagert - mehrere Jahrtausende problemlos überdauern kann und nahezu unbegrenzt haltbar ist, wie archäologische Funde belegen.[6]

Zudem ist es möglich, dass man in einem Kubikmillimeter DNA-Speicher ein Exabyte (1018 Bytes) speichern kann, also eine Milliarde Gigabyte.[7] Um diese Zahl vielleicht etwas begreifbarer zu machen: Der gesamte Datenbestand weltweit wird im Jahr 2020 auf etwa 64.000 Exabytes geschätzt.[8] In einem theoretischen DNA-Speicher in Würfelform mit einer Kantenlänge von 4cm würde dieses gesamte Wissen exakt reinpassen!

Somit wäre die Speicherung von unvorstellbaren Datenmengen nicht mehr zwingend an ein großes Volumen gekoppelt. Doch aktuell ist es noch sehr teuer und aufwendig auch nur kleine Stücke Daten zu speichern. So liegt der aktuelle Preis für ein Megabyte zu speichern aktuell bei knapp 500 €, weshalb eine kosteneffiziente Speicherung damit noch nicht realisiert werden kann.

Der DNA-Speicher hat jedoch im Gegenteil zu der Speicherung auf Mikrofilm einen entscheidenden Nachteil, da er weitaus schwieriger auszulesen ist und somit gerade für eine Zivilisation, deren Wissensbestand zerstört ist, kaum einfach zu entziffern wäre. Mikrofilme hingegen benötigen lediglich eine starke optische Vergrößerung, die durchaus auch mit rudimentären physikalischen Kenntnissen und primitiven Werkzeugen realisiert werden kann. Um DNA hingegen entziffern zu können, müsste eine Zivilisation mit untergegangenem Wissensstand sich erstmal zu dem Punkt hinarbeiten, an dem sie selbst in der Lage ist, diese zu entziffern. Womit sich die Frage stellt, ob das Wissen, außer zu historischem Interesse, dann überhaupt noch von Belang wäre.

Eine Lösung könnte jedoch sein, dass auf Mikrofilm eine Anleitung zu Dekodierung von DNA enthalten ist und das eigentliche Wissen in der DNA selbst kodiert ist.

Kennzeichnungsprobleme

Doch wie kennzeichnet man, wie die Vergrößerung des Mikrofilms überhaupt funktioniert und wie codiert man die optischen Informationen darauf selbst? Je nach dystopischem Szenario könnte es durchaus passieren, dass zwischen der Wiederentdeckung der Wissenssammlung und der Erstellung große Zeitabstände verstreichen und sich infolgedessen die Sprache und auch die Kultur stark wandelt.

Genau mit diesem Aspekt beschäftigen sich Semiologen aktuell im Kontext der Kennzeichnung von atomaren Endlagern. Die Atomsemiotik versteht sich als „Lehre von den Zeichen, die im Rahmen von mit Atomenergie verbundenen Problemen nutzbar gemacht werden kann“[9] und betrachtet daher den umgekehrten Fall, da hier nicht angelockt, sondern gewarnt werden muss. Denn bei den atomaren Endlagern muss sichergestellt werden, dass selbst in 24.000 Jahren (der Halbwertszeit von Plutonium-239) noch ersichtlich ist, dass hier Gefahr lauert und nicht etwa ein vergrabener Schatz – und das unabhängig von Sprache und Kultur.

Man könnte sich also an deren Lösungsvorschlägen bedienen, die aktuell in drei verschiedene Richtung gehen: Zum einen könnte man physikalische Hinweise schaffen, die redundant auf die Gefahren aufmerksam machen und Strahlung durch elektrotechnische Methoden sichtbar machen. Ebenso wäre hierbei denkbar, dass man Informationen redundant auf nahezu unverwüstlichen Materialien piktografisch darstellt. Eine andere Option könnte sein, dass man Informationen an lebendige Organismen weitergibt, z. Bsp über speziell gezüchtete Blumen, die so nirgendwo sonst vorkommen und durch ihre farbliche Komponente abschrecken. Die dritte Option wäre eine kulturelle Komponente, die einen kleinen aber konstanten Kreis aufgeklärter Menschen dazu verpflichtet dieses Wissen zu wahren und weiterzugeben und zwar an ausgesuchte Nachfolger, die sich wiederum verpflichten, diese Informationslinie fortzuführen. Das Ganze erinnert stark an eine sektenartige Geheimgesellschaft und wird daher auch als „Atompriesterschaft“ bezeichnet.

Fazit

Hier schließt sich wiederum der Kreis zur Foundation-Trilogie von Asimov, da er mit dem Konzept der Enzyklopädisten, die einsiedlerisch am Rande der Galaxie leben, genau dieses Konzept nutzt, um die Informationen über Generationen hinweg weiterzugeben. Zwar nutzt er auch noch weitere futuristische Hilfsmittel, doch erfüllen diese größtenteils nur den Zweck eines kulturellen Erinnerungsmonuments.

Die Speicherung des Wissens der Menschheit über lange Zeiträume ist also gar nicht so unmöglich wie es auf den ersten Blick erscheinen mag, denn auch wenn es viele Hindernisse geben mag (mehr als hier skizziert), so gibt es bereits viele Antworten darauf oder diese werden in den kommenden Jahren serienreif zur Verfügung stehen.

Die Gefahr, dass das menschliche Wissen und die Errungenschaften der letzten Jahrtausende verlorengehen, ist omnipräsent und das Budget für ein solches Unterfangen wäre im Vergleich zur Mitigation des Risikowerts kaum relevant.

Aus diesem Standpunkt heraus würde es Sinn ergeben, solche Vorkehrungen bereits jetzt zu treffen und in einem internationalen Projekt zu bündeln!

Denn Katastrophen werden die Menschheit noch einige treffen, seien es Selbstgemachte, wie Atomkriege oder der anthropogene Klimawandel, oder aber Naturkatastrophen oder kosmische Ereignisse. Die Menschheit wurde bereits vor vermutlich 70.000 Jahren durch Vulkanausbrüche auf 1.000 bis 10.000 Individuen dezimiert. Dies kann jederzeit wieder passieren.

Was hält uns also davon ab, für die Überlebenden einer solchen Katastrophe das Wissen der vorangegangenen Menschheit bereitzustellen? Was, außer unserer eigenen Hybris?

[1] Ordnung ist das halbe Leben! Die ältesten Listen in Mesopotamien (um 3300 v. Chr.)

[5] Netzsperren durch die CUII: Private Rechtsdurchsetzung zulasten der Grundrechte Dritter

[6] A Characterization of the DNA Data Storage Channel

[8] Volume of data/information created, captured, copied, and consumed worldwide from 2010 to 2025

[9] Atomsemiotik – semiotische Probleme von Atommüll und Zeichen als Warnungen an die ferne Zukunft